Juan Arturo Muñoz Anaya. Robótica Juárez. Mayo 2009.

pololos28@gmail.com.

http://roboticajuarez.blogspot.com

I. Introducción

La capacidad de visión dota a un robot de un sofisticado mecanismo de percepción que permite a la máquina responder a su entorno de una forma inteligente y flexible. Esta aumenta los campos de aplicación de los sistemas de robótica.

La visión se considera la más potente capacidad sensorial de un robot. Con ello, el hardware y los procesos asociados con la visión artificial son considerablemente más complejos. Esta capacidad y funcionalidad, específicamente su uso en las misiones al planeta Marte (y próximamente de nueva cuenta a nuestra Luna) tiene una amplia gama de aplicaciones por lo gran necesidad de dotar de un alto grado de autonomía a los robots exploradores por la imposibilidad actual del humano de estar ahí.

II. Definición de visión

En la Vigésima segunda edición del Diccionario de la lengua española, encontramos que:

visión.

(Del lat. visĭo, -ōnis).

2. f. Contemplación inmediata y directa sin percepción sensible.

El ojo es el órgano que detecta la luz, siendo la base del sentido de la vista.

Se compone de un sistema sensible a los cambios de luz, capaz de transformar éstos en impulsos eléctricos. Los ojos más sencillos no hacen más que detectar si los alrededores están iluminados u oscuros. Los más complejos sirven para proporcionar el sentido de la vista.

Las partes del ojo son esenciales para la existencia humana porque gracias a ellas captamos, percibimos y encontramos lo que se llama las imágenes percibidas por este sistema. [3]

El ojo humano esta conformado de pupilas, iris, lente y retina. La pupila es una abertura que permite a la luz pasar al interior del ojo. La pupila está controlada por el iris (la parte de color de su ojo) que es un músculo que se contrae para hacer la pupila más pequeña y se relaja para hacer la pupila más ancha. El tamaño de la pupila está relacionado con que tanta luz haya en un ambiente en particular. El lente del ojo está colocado tras el iris. El lente enfoca la luz en la retina, que actúa como pantalla. Hay dos tipos células sensitivas de luz en la retina: varillas y conos. Las varillas son utilizadas para la visión en blanco y negro, y están concentradas en los lados de la retina. Los conos son usados para la visión de color y están concentrados en el centro de la retina. [1]

Fig. 1. El ojo humano. [4]

¿Las máquinas (ó los robots) ven?

Sí, a través de la visión artificial.

III. Sistema de visión artificial ó visión por computadora

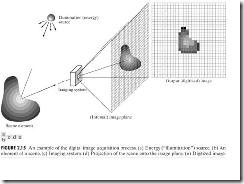

La información visual se convierte en señales eléctricas por sensores visuales. La visión artificial se puede definir como los procesos de obtención, caracterización e interpretación de información de imágenes tomadas de un mundo tridimensional.

Fig. 2. Algunas aplicaciones de la visión por computadora. [2a]

Fig. 3. El pulsar "Cangrejo" visto con diferentes receptores. Digital image processing - Rafael C. Gonzalez, Richard Eugene Woods

Las aplicaciones de la visión por computadora se pueden clasificar por su fuente de energía, la más común es el espectro electromagnético como por ejemplo luz visible por el hombre, los rayos gama ó rayos X. Asimismo, también existen las imágenes formadas a partir de ondas de radio. Dado que esta incluido en el espectro electromagnético y además hay diversas fuentes de emisión de ondas radiales, como por ejemplo algunas estrellas, esta aplicación es muy común en el campo de la astronomía.

Proceso de obtención ó captación.

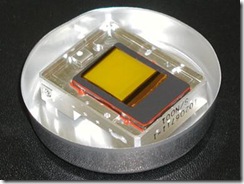

Es la parte física del sistema, la óptica (cámara, filtros, lentes) y la parte electrónica. (sensores, filtros y procesadores) Nos enfocaremos en estos últimos. Los principales dispositivos usados para la visión artificial son los sensores de imagen de estado sólido y los dispositivos de acoplamiento de carga. (Charge Coupled Device) Estos dispositivos estan presentes en la mayoria de las aplicaciones de visión actuales.

El sensor de imagen esta compuesto por millones de pequeños semiconductores de silicilio, los cuales captan los fotones (elementos que componen la luz, la electricidad). A mayor intensidad de luz, más carga eléctrica existirá. Estos fotones desprenden electrones dentro del sensor de imagen, los cuales se transformarán en una serie de valores (datos digitales) creando un píxel. Por lo tanto cada célula que desprenda el sensor de imagen se corresponde a un píxel, el cual, formará cada punto de la imagen.

Fig. 4. Sensor de Imagen. [2d]

El sensor CCD (Charge Coupled Device), dispositivo de carga acoplada. Este sensor es uno de los más comunes y más utilizados en la imagen digital. Proporciona buena calidad de imagen, pero por otro lado su fabricación es muy compleja y costosa, por lo que lo fabrican pocas empresas. Las cámaras digitales que llevan incorporado esta clase de sensor, tienen un coste compra elevado. Esta clase de sensor consume mucha energía.

Fig. 5. Sensor CCD. [2e]

El funcionamiento del sensor CCD, necesita de un chip externo denominado analog - digital converter o ADC, que es el que se encarga de convertir los datos de cada píxel en datos digitales binarios, para que nuestra computadora (ordenador) los pueda leer.

La mayoria de los sensores tienen el mismo principio, un chip que convierte la energía captada a información digital (1's y 0's) en forma de señal eléctrica.

Procesamiento (caracterización) e interpretación.

El procesamiento e interpretación se tratan por igual ya que ambos se obtienen a través del mismo método. Estos utilizan otro chip llamado Microprocesador y se inicia con el "muestreo". La señal eléctrica obtenida del sensor óptico es "segmentada" en un número finito de muestras las cuales es posible cuantificar y computar. A dicha muestra se le asigna un número 0 a 255. Una vez muestreada, el microprocesador a través de diversas ecuaciones matriciales, (que no analizaremos aquí) convierte la imagen en elementos de imagen ó pixeles. Cada píxel forma un área relativamente pequeña respecto a la imagen total. A mayor cantidad de pixeles, mejor es la resolución ó nitidez. Entonces, por imagen podemos entender: Arreglo bidimensional de píxeles de diferente intensidad luminosa. (escala de gris)

Fig. 6. Ejemplo de obtención y procesamiento de una imagen.

La aplicación del procesamiento de la imagen debe considerar el espacio de almacenamiento de la misma. Una imagen de 1 x 1 pixeles equivale a 1 byte, 1024 x 1024 requiere 1 Megabyte. (1,000 bytes)

También existen sensores específicos que permiten generar imágenes espectroscópicas, esto es, que permiten la captura de luz con longitudes de onda más allá de la visible, como la infrarroja. Con esta información se puede, por ejemplo, conocer los compuestos químicos así como la temperatura de una estrella ó la superficie de un planeta, como Marte. Cada longitud de onda tiene asignado un color según su ubicación en el espectro electromagnético.

Fig. 7. Espectro electromagnético. [9]

Todas las imágenes tienen "defectos" ó ruido. Este se debe generalmente a la cámara y/o al medio de transmisión de la señal internamente en el hardware. Este es procesado ó atenuado a través de algoritmos matemáticos en el procesador.

A partir de este punto, ya es posible la manipulación total de la imagen: rotaciones, control de brillo y contraste, hacerla más grande ó más chica, asimismo, una de las aplicaciones más útiles: las imágenes tridimensionales ó 3D. Las también llamadas imágenes de perspectiva, también son producto del nada \-complejo cómputo matricial, sin embargo hay una cuestión que es importante comentar: la profundidad de una imagen usando técnicas de tratamiento estereoscópicas. (Estereo) Para las imágenes estereo se necesitan 2 cámaras. La formación de una imagen de este tipo conlleva obtener dos vistas distintas del objeto. La distancia entre el centro de las dos lentes se llama línea base y el objetivo es hallar las coordenadas X, Y, Z de un punto w.

Otra Una de las aplicaciones más comunes es la caracterización, la cual consiste en ubicar elementos específicos en una imagen, por ejemplo, un robot que necesite detectar obstáculos para esquivarlos.

NOTA: El campo visual humano es de 120 grados en horizontal y 60 grados en vertical, nos da un total de 576 megapíxeles de datos. [6]

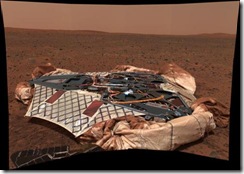

IV. Caso de ejemplo: Mars Exploration Rovers

En 2003, fueron enviados 2 vehículos tipo rover (explorador) al planeta rojo. Cada vehículo lleva un sofisticado juego de instrumentos que le permitirá buscar en el planeta evidencias de presencia de agua en estado líquido en el pasado. Entre este equipo, se encuentran cámaras especializadas que, usando imágenes y espectros tomados diariamente desde los rovers, los científicos los guían hacia los objetivos de rocas y suelos de interés, para evaluar su composición y textura a escalas microscópicas.

Fig. 8. Imagen conceptual del rover Spirit. [2f]

Fig. 9. Vista "normal" y estereoscópica de la superficie Marciana por el rover Spirit. [2f]

Las exploraciones en la superficie y en el subsuelo para buscar señales de vida representan un tremendo desafío. Los criterios de detección de vida que funcionarían para la vida terrestre no serían suficientes, pues debemos considerar la posibilidad de que la vida en Marte haya surgido independientemente y de que sus atributos sean totalmente diferentes de lo que nosotros entendemos como vida aquí en la Tierra. Los científicos están desarrollando ahora técnicas que pueden dar cabida a una amplia gama de posibilidades. Es probable que los detectores de vida incluyan tecnologías de generación de imágenes de alta resolución a nivel microscópico, o instrumentos que analicen formas y estructuras en múltiples longitudes de onda que puedan reconocer patrones asociados a los organismos vivientes, y sensores que permitan detectar las “firmas” químicas de la vida.

Fig. 10a. Módulo de amartizaje. [6]

El desplazamiento del explorador es todo un reto dado que el tiempo de comunicación entre la tierra y Marte toma aproximadamente 20 minutos. De esta manera, los conductores de los rovers no tienen manera de saber instantáneamente que sucede y no tienen manera de enviar inmediatamente comandos que lo prevengan de golpearse con una roca ó caer por un barranco. Cada sol marciano, que equivale a 24 horas y 37.5 minutos terrestres, se le envían asignaciones de a donde debe moverse y que experimentos efectuar. De esta manera, el vehículo automáticamente ejecuta estas instrucciones. Es por eso que debe tener un gran sistema de instrumentos auxiliares que le permitan realizar de una manera segura su misión. Para esto, los rovers cuentan con 6 cámaras de navegación y 3 científicas.

Fig. 10b. Cámaras auxiliares del rover. [5]

Cámaras de prevención de riesgos. (Hazard Avoidance Cameras)

Son 4, ubicadas en la parte inferior del vehículo 2 posicionadas al frente y otras dos posicionadas atrás. Estás generan una imagen 3D que cuida de que el rover se pierda ó choque con obstáculos no previstos. Estas imágenes son interpretadas por los procesadores comentados anteriormente. Estás cámaras tienen un campo de visión de 120 grados horizontales. Con ellas hacen un mapa de la forma del terreno que abraca hasta 4 metros. No tienen movimiento, es decir, siempre "ven" hacia la misma dirección.

Fig. 11. Camino "peligroso" en Marte.

Cámaras de navegación. (NavCams/Navigation Cameras)

Montadas en el mástil del rover. Generan imágenes panorámicas tridimensionales blanco y negro. Son 2 y tienen un campo de visión de 45º que le dan apoyo a las cámaras de prevención de riesgos para formar una vista completa del terreno.

Fig. 12a. Mapa del camino recorrido. [7]

Fig. 12b. Mapa del camino a recorrer. [7]

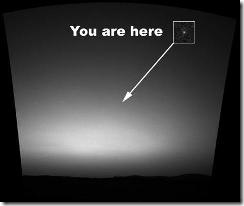

Cámaras panorámamicas. (Pancam/panoramic Cameras)

Las panorámicas generan imágenes estereo a color. A través del mástil, estas pueden rotar 360º horizontal, con la posibilidad de crear imágenes de 24,000 píxeles y 180º vertical para hasta 4,000 píxeles. Con ellas se generan mapas para navegación para así darle información a los científicos hacia donde dirigir el rover para estudiar rastros de agua principalmente.

Fig. 13a. Pancams y su sensor CCD. [5]

Tienen la misma resolución que un humano lo que permite una vista como si un geólogo estuviera ahí en Marte. También, esta cámara tiene 11 filtros de color y 2 filtros solares para tomar imágenes multiespectrales para conocer la composición química del suelo y las rocas.

Fig. 13b. Imagen espectroscópica de la superficie Marciana. [7]

Fig. 14c. Imagen panorámica 360º de Marte. [7]

Cuando se colocan los filtros solares las pancams son apuntadas hacia el sol y usarlo como referencia para la navegación.

Fig. 13c. Pancams. [5]

Fig. 13d. La tierra vista desde Marte. [7]

Cámara para imágenes microscópicas. (Microscopic Imager)

Esta formada por la combinación de un microscopio y un CCD. Tiene una resolución de 1024x1024 píxeles. Es monocromática, esto es, a blanco y negro, está montada al brazo robótico que le permite hacer tomas extremadamente precisas por medio del acercamiento a las rocas y el suelo. Su aplicación es conocer las propiedades del suelo y rocas pequeñas para identificar si hubo agua en el pasado del planeta. También para saber que impacto pueden tener en la movilidad del rover.

Fig. 14. Microscopic Imager y un ejemplo de una roca vista con esta cámara. [5]

V. Conclusión

Probablemente nos tome muchísimas páginas escribir sobre este interesante tema. Sin embargo, es más interesante las aplicaciones en que derivan estas técnicas, que son utilizadas para la solución de muchos problemas de todo tipo en nuestro planeta. Si no es así, vana es la investigación y el derroche de recursos humanos, económicos y naturales.

Bibliografía y ligas de interés

1. Digital image processing

Escrito por Rafael C. Gonzalez, Richard Eugene Woods

Edition: 3, illustrated

Publicado por Prentice Hall, 2007

ISBN 013168728X, 9780131687288

2. Fundamentos para el procesamiento de imágenes

Publicado por UABC

ISBN 9707350164, 9789707350168

[1] http://library.thinkquest.org/C003776/espanol/book/ojo_humano.htm - Mayo 2009.

[2a] Image and Vision Computing Group is a research group with the Department of Computer Science and Technology, Tsinghua University. media.cs.tsinghua.edu.cn/~imagevision/. May 2009

[2d] http://www.digitalfotored.com/imagendigital/sensorimagen.htm. May 2009.

[2e] http://www.digitalfotored.com/imagendigital/sensorccd.htm. May 2009.

[2f] http://marsrover.nasa.gov/gallery/press/spirit/20041217a.html. May 2009.

[3] http://es.wikipedia.org/wiki/Ojo. May 2009.

[4] www.monografias.com/trabajos5/ojo/. May 2009.

[5] http://marsrover.nasa.gov/mission/spacecraft_surface_rover.html. May 2009

[6] http://cosassencillas.wordpress.com/2007/03/20/la-vision-humana-equivale-a-576-megapixeles/.May 2009.

[7] http://athena.cornell.edu/the_mission/ins_pancam_frommars.html. May 2009.

[8] http://es.wikipedia.org/wiki/Espectro_electromagn%C3%A9tico. May 2009.